在当今数字化时代,网络服务的稳定性与高可用性至关重要。无论是大型电商平台应对促销洪峰,还是在线服务提供商确保全球用户流畅访问,背后都离不开一项核心基础设施技术——网络负载均衡。本文旨在深入浅出地解析网络负载均衡技术的基本原理、主要类型及其广泛的应用场景。

一、网络负载均衡技术概述

网络负载均衡(Network Load Balancing, NLB)是一种将网络流量或计算任务智能地分配到多个服务器或网络设备上的技术。其核心目标在于:

- 提升性能:通过并行处理,避免单一服务器过载,缩短用户请求响应时间。

- 保证高可用性:当集群中某台服务器发生故障时,负载均衡器能自动将流量导向其他健康的服务器,实现服务不中断。

- 增强可扩展性:可以方便地通过增加服务器节点来水平扩展系统处理能力,以应对业务增长。

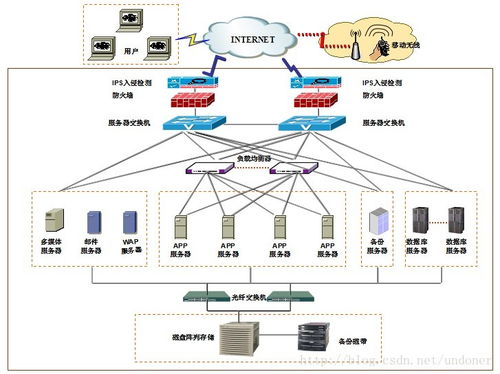

负载均衡器作为流量调度中心,通常位于客户端与服务器集群之间,根据预设的算法和实时健康检查结果做出决策。

二、主要负载均衡技术与算法

负载均衡技术可以从不同层面实现,主要分为以下几类:

- 基于OSI模型的分类:

- 四层负载均衡(传输层):基于IP地址和TCP/UDP端口进行流量分发。它处理效率高,速度快,但对应用层内容无感知。常见协议如TCP、UDP。LVS(Linux Virtual Server)是典型的四层负载均衡代表。

- 七层负载均衡(应用层):能够解析HTTP/HTTPS等应用层协议,根据URL、Cookie、HTTP头部等信息进行更精细化的流量调度。这使得它能够实现基于内容的路由、SSL终结、缓存优化等高级功能。Nginx、HAProxy是强大的七层负载均衡软件。

- 常见调度算法:

- 轮询:将请求依次分配给每台服务器,实现简单、绝对公平。

- 加权轮询:根据服务器性能(如CPU、内存)分配不同的权重,性能高的服务器承担更多请求。

- 最少连接:将新请求发送到当前连接数最少的服务器,适用于长连接场景。

- 源IP哈希:根据客户端IP地址计算哈希值,将同一IP的请求始终定向到同一台服务器,有利于会话保持。

- 最短响应时间:将请求导向平均响应时间最短的服务器,以优化用户体验。

三、网络负载均衡的关键应用场景

- Web网站与应用服务:这是负载均衡最经典的应用。通过将HTTP/HTTPS请求分发到多个Web服务器(如Apache、Tomcat集群),轻松应对高并发访问,保证网站快速响应且7x24小时在线。

- 微服务架构:在微服务体系中,服务发现与负载均衡是基石。API网关或服务网格(如Istio)内部集成了负载均衡功能,能够动态地将服务调用请求分发到后端的多个服务实例上,实现服务的弹性伸缩与容错。

- 数据库读写分离:对于数据库集群,负载均衡器可以将写操作定向到主库,而将大量的读操作均匀分发到多个从库,显著提升数据库的整体读写性能和并发处理能力。

- 全局服务器负载均衡:当业务部署在多个数据中心或云区域时,GSLB基于地理位置、服务器健康状态和链路状况,将用户请求定向到最优的数据中心,实现异地容灾和流量全局调度,提升跨地域访问速度。

- 安全防护与流量清洗:负载均衡器可以作为安全屏障,与防火墙、WAF(Web应用防火墙)协同工作。它能够识别并拦截恶意流量,将正常的业务流量分发到后端,在遭遇DDoS攻击时配合高防IP进行流量清洗。

四、技术选型与实施考虑

在选择和实施负载均衡方案时,需综合考虑:

- 业务需求:是需要高性能的四层转发,还是需要智能的七层内容路由?

- 部署模式:采用硬件负载均衡设备(F5、A10)性能强大但成本高;采用软件负载均衡(Nginx、LVS、HAProxy)灵活、成本低,是互联网公司的普遍选择;云服务商(如AWS的ALB/NLB、阿里云的SLB)提供的托管式负载均衡则开箱即用,运维简单。

- 高可用架构:负载均衡器本身不能成为单点故障,通常需要以主备或集群方式部署。

- 可观测性:完善的监控(如QPS、响应时间、后端服务器健康状态)和日志记录对于故障排查和性能调优不可或缺。

###

网络负载均衡已从一项可选的高级功能,演变为构建现代化、高可用、可扩展网络服务的标准配置。理解其原理并合理应用,能够有效提升IT基础设施的弹性、效率和可靠性,为业务的稳定运行和持续增长奠定坚实的技术基础。随着云原生和边缘计算的发展,负载均衡技术也正朝着更智能、更自动化的方向持续演进。